En las guías anteriores (nivel básico e intermedio) aprendimos los fundamentos de los prompts: cómo estructurar instrucciones claras, dar contexto y ejemplos simples. En este tercer nivel elevaremos la complejidad y veremos Prompt Engineering nivel PRO: técnicas profesionales de prompt engineering que permiten resolver tareas estratégicas (consultoría, toma de decisiones, generación de frameworks complejos, etc.) con LLMs avanzados.

Contenidos

Técnicas avanzadas de promp engineering nivel PRO para aplicaciones estratégicas

Abordaremos técnicas como cadena de pensamiento (Chain-of-Thought), aprendizaje con ejemplos (few-shot prompting), mensajes de sistema (system prompts) y meta-prompts, entre otras. Cada técnica se explica a nivel técnico y se ilustra con ejemplos prácticos de promp engineering nivel pro aplicados a escenarios de negocio y estrategia. Como en las guías anteriores, incluiremos referencias (citadas al final) para fundamentar los conceptos avanzados.

Cadena de pensamiento (Chain-of-Thought Prompting)

La incitación a la cadena de pensamiento (CoT) es una técnica que le pide al modelo LLM que razone paso a paso antes de dar la respuesta final. En lugar de exigir directamente la solución, se induce al modelo a “pensar en voz alta” o desglosar el problema en subtareas.

De esta forma, el modelo genera explícitamente un proceso intermedio de razonamiento en lenguaje natural. Las investigaciones han demostrado que esto mejora significativamente el rendimiento del modelo en tareas complejas o multietapa (aritmética, razonamiento lógico, problemas de varios pasos, etc.).

En palabras simples: CoT obliga al modelo a detallar cada paso intermedio, evitando que “salte” directamente a una respuesta que suene plausible pero errónea.

La eficacia de CoT se debe a que simula el razonamiento humano desglosando el problema en partes manejables.

Por ejemplo, Wei et al. (2022) mostraron que guiar al modelo con ejemplos de razonamiento («cada paso…») aumenta notablemente su precisión en problemas matemáticos y lógicos.

De hecho, sin CoT muchos modelos grandes fallan en tareas simples que requieren varios pasos mientras que al inducir el razonamiento intermedio sí alcanzan la respuesta correcta . En resumen, la cadena de pensamiento le da al LLM más tiempo y contexto interno, enfocando su “atención” en una parte del problema a la vez y reduciendo errores por omisión . En la práctica, hay dos formas principales de aplicar CoT en un prompt:

Instrucciones explícitas para Prompt Engineering nivel PRO:

- Desglosar la consulta con frases guía:

Usar incisos numerados o indicaciones como “En primer lugar, haz esto… Luego…” en el mismo prompt de usuario, para que el modelo articule cada paso. - Instrucciones implícitas:

Añadir al final de la pregunta original frases como “Pensemos paso a paso” o “Explícalo con detalle antes de dar la respuesta”. Este simple añadido incita al modelo a 5 razonarlo internamente.

Ambas estrategias han demostrado ser efectivas. En experimentos de investigación se observa que incluso con una instrucción minimalista (“Pensemos paso a paso”), los grandes modelos comienzan a exponer su razonamiento interno y mejoran drásticamente la exactitud.

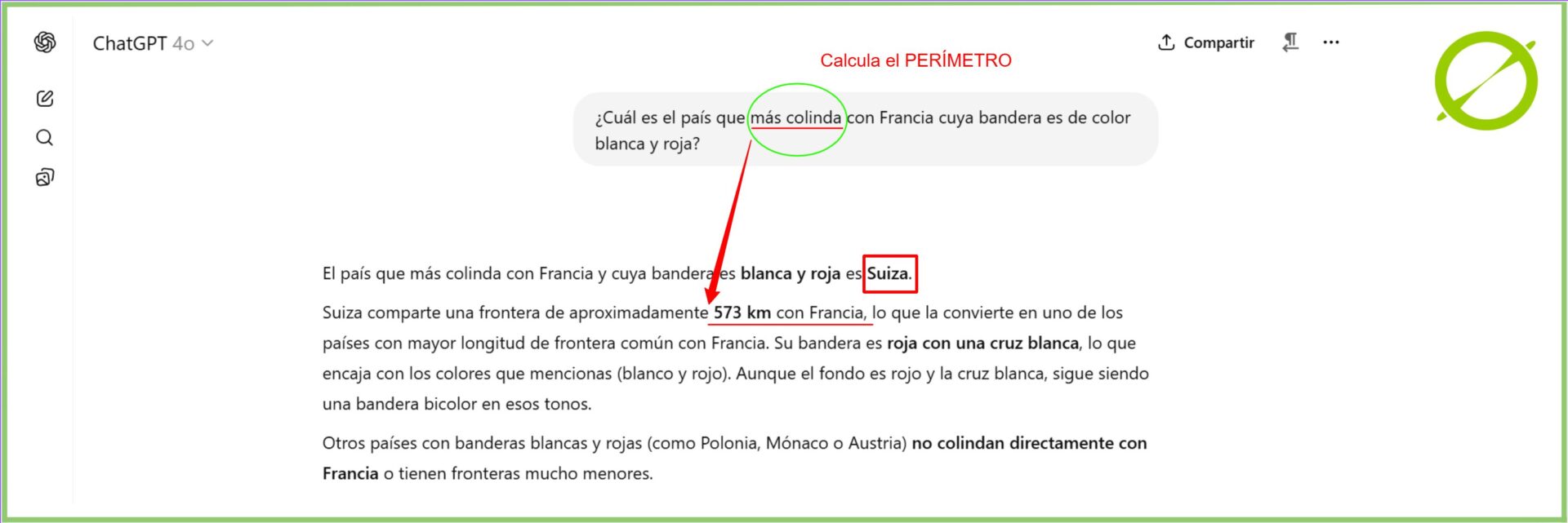

Ejemplo conceptual de Prompt Engineering nivel PRO: Ante la pregunta: “¿Cuál es el país que más colinda con Francia cuya bandera es de color roja y blanca?”, un modelo que aplica razonamiento paso a paso (CoT) podría proceder del siguiente modo: “Pensemos: Francia limita con varios países: Bélgica, Alemania, Suiza, Italia, España, Andorra y Mónaco. Ahora, de entre ellos, buscamos aquel cuya bandera sea de color roja y blanca. Suiza cumple esta condición, ya que su bandera es roja con una cruz blanca. Además, entre los países mencionados, Suiza es uno de los que tiene mayor longitud de frontera con Francia. Por tanto, la respuesta correcta es Suiza.”

Este tipo de razonamiento permite llegar a la solución correcta sin necesidad de ejemplos previos, descomponiendo el problema en pasos lógicos.

Aprendizaje con ejemplos (Few-Shot Prompting)

En few-shot prompting (también llamado “aprendizaje en contexto”), proporcionamos al modelo varios ejemplos de la tarea que queremos que realice. Se incluyen ejemplos de entrada-salida (demostraciones o exemplars) en el prompt para que el modelo “aprenda” el patrón deseado. A diferencia del cero-shot (sin ejemplos) o del fine-tuning, en few-shot el modelo usa directamente esos pocos ejemplos dentro del prompt para guiar su respuesta.

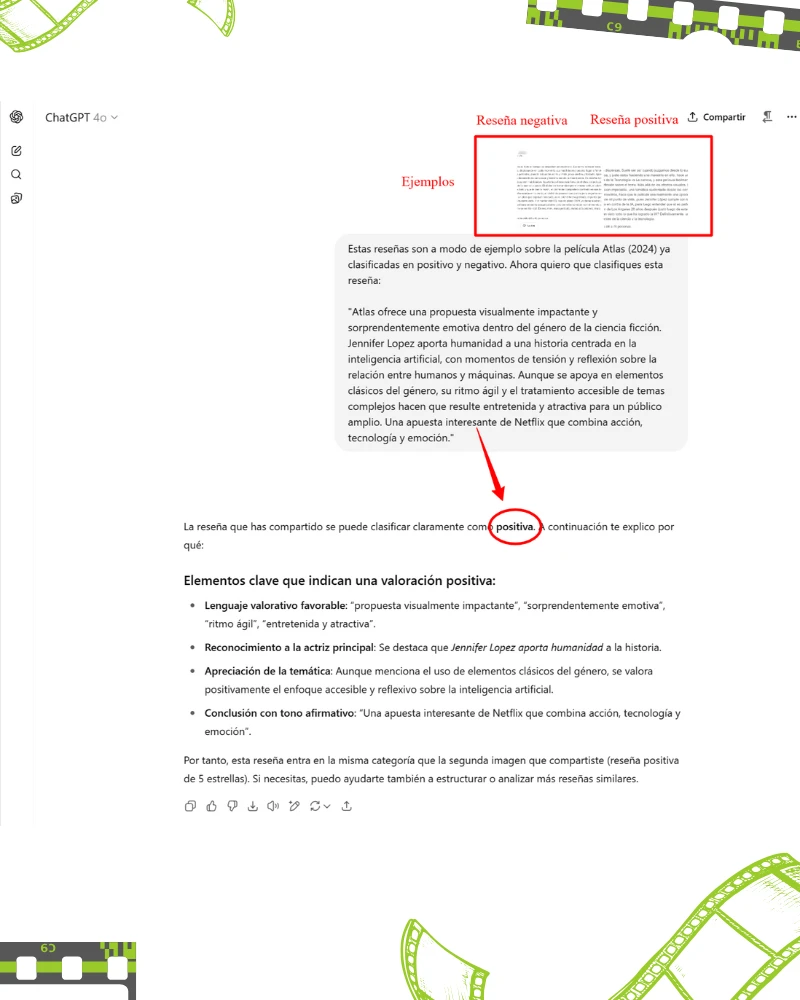

Ejemplo práctico de de Prompt Engineering nivel PRO: podríamos incluir dos reseñas de películas ya clasificadas en “Positivo”/“Negativo” y luego pedir la clasificación de una nueva reseña; el modelo usará los ejemplos como referencia de formato y estilo.

Para el ejemplo se han tomado de referencia dos reseñas de Google (una positiva y una negativa) sobre la película Atlas (2024):

¨Le das al modelo unos cuantos ejemplos rápidos para mostrarle lo que quieres, facilitándole la comprensión y la realización correcta de la tarea” -DataCamp

Esta técnica es muy útil y potente, porque aprovecha el conocimiento preexistente del modelo y lo adapta rápidamente a tareas concretas sin re-entrenamiento pesado. Según DataCamp, “el prompting de pocos disparos es un método inteligente que ayuda a conectar lo que el modelo ya sabe con lo que necesitamos que haga para un trabajo concreto: ¨le das al modelo unos cuantos ejemplos rápidos para mostrarle lo que quieres, facilitándole la comprensión y la realización correcta de la tarea” . En otras palabras, los ejemplos le muestran al LLM “así es como debe responder”, reduciendo ambigüedad y ajustando el estilo o formato deseados.

En la práctica, se suele estructurar el prompt con: primero uno o más ejemplos (entrada y salida) claros y formateados, y al final la nueva entrada cuya salida se desea. Los ejemplos deben ser representativos de la tarea. Por ejemplo, para generar un balance SWOT (Fortalezas-Debilidades-Oportunidades Amenazas) de empresas, podríamos incluir primero dos análisis SWOT ya realizados de otras empresas, y luego pedir el análisis para la tercera. Esto condiciona al modelo a seguir el mismo formato y nivel de detalle.

No obstante, few-shot tiene limitaciones. Como se observó en pruebas con el ejemplo de “números impares suman pares” , a veces varios ejemplos no bastan para resolver tareas muy complicadas. Si la tarea requiere numerosos pasos lógicos, puede ser mejor combinar few-shot con CoT o explorar técnicas más avanzadas. En general, se recomienda utilizar few-shot cuando la tarea tiene un formato claro y podemos dar ejemplos relevantes; si el modelo aún falla, conviene probar dividir la tarea en pasos (con CoT o prompt chaining).

Mensajes de sistema (System Prompts) y roles del modelo

Un mensaje de sistema es un conjunto de instrucciones globales que define el comportamiento general del modelo antes de procesar cualquier mensaje de usuario. En muchas API de chat (como la interfaz ChatGPT), se introducen tres tipos de mensajes: mensaje de sistema, mensaje de usuario y mensaje de asistente. El mensaje de sistema dicta el rol, la personalidad, el tono y las directrices generales del modelo . Por ejemplo, un mensaje de sistema puede indicar “Eres un experto consultor en estrategia empresarial” o “Actúa como un analista financiero preciso y objetivo”.

Estas instrucciones de sistema funcionan como un marco contextual global: definen quién es el modelo ante cada conversación.

“Los system prompts sirven como instrucciones fundamentales que dictan el comportamiento de la IA. Definen el rol de la IA, su área de experiencia y el tono que debe adoptar”. –ZeroMoment

Aunque en la interfaz pública de ChatGPT el mensaje de sistema suele estar predefinido por el sistema (por ejemplo, “eres un asistente útil”), al diseñar prompts podemos emular este efecto con indicaciones iniciales. Por ejemplo, incluir al inicio del prompt líneas como “Sistema: Eres un consultor senior” tiene el mismo propósito de fijar el contexto.

Existen indicios de que que el LLM maneja internamente roles: “típicamente hay un mensaje de sistema (instrucciones globales), tus mensajes de usuario y las respuestas del asistente. Al usar la interfaz normal, controlas principalmente el mensaje de usuario… al diseñar prompts puedes incluir indicaciones de rol o contexto (‘Eres un bot de servicio al cliente…’) que cumplen una función similar a un mensaje de sistema” . En la práctica, esto significa que definir el rol desde el inicio del prompt (p.ej. “Actúa como un experto en X”) orienta todas las respuestas siguientes hacia ese perfil especializado.

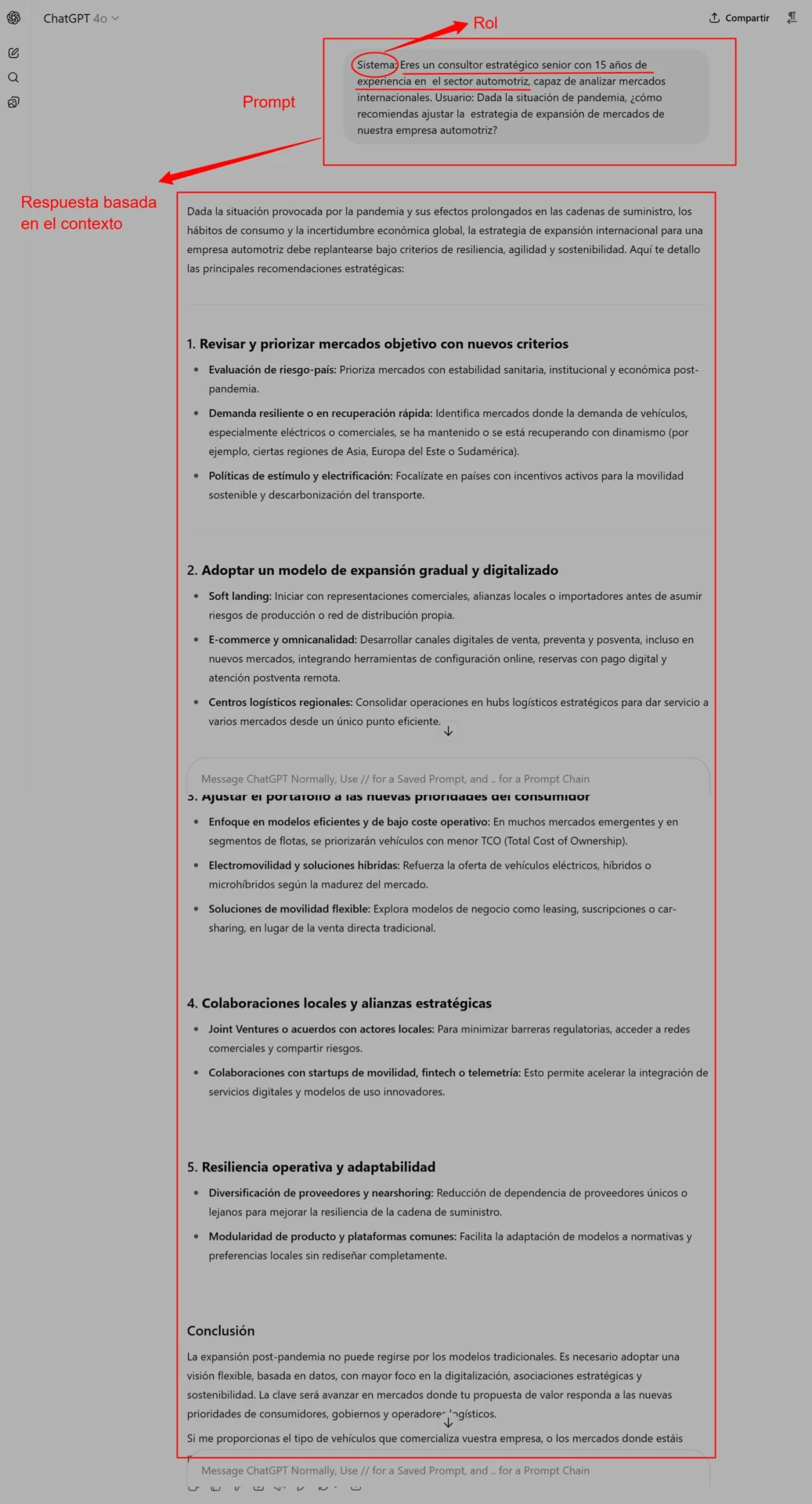

Ejemplo de de Prompt Engineering nivel PRO de sistema:

Sistema: Eres un consultor estratégico senior con 15 años de experiencia en el sector automotriz, capaz de analizar mercados internacionales. Usuario: Dada la situación de pandemia, ¿cómo recomiendas ajustar la estrategia de expansión de mercados de nuestra empresa automotriz?

En este prompt, la línea “Sistema:” guía al modelo hacia un comportamiento consistente con un “consultor estratégico senior”. Todo lo que responda a continuación estará influenciado por ese marco (vocablo técnico, consideraciones de consultoría, referencias a estrategias globales, etc.). Los mensajes de sistema son especialmente útiles en entornos multi-turn, donde el modelo debe mantener coherencia de largo plazo.

Meta-prompts (generación dinámica de prompts)

El meta-prompting es una técnica avanzada de Prompt Engineering nivel PRO en la que el propio modelo LLM ayuda a diseñar, refinar o mejorar prompts. En lugar de escribir manualmente un prompt perfecto desde cero, usamos un LLM más inteligente o de soporte para iterar sobre el texto del prompt y optimizarlo. Dicho de otro modo, el modelo aprende a “ingeniería de prompts” consigo mismo.

“El uso de modelos de lenguaje grandes para generar y mejorar prompts dinámicamente”. –LinkedIn

LinkedIn describe Meta-Prompting como “el uso de modelos de lenguaje grandes para generar y mejorar prompts dinámicamente”, en lugar de escribir un prompt manualmente y esperar lo mejor.

En la práctica, esto puede hacerse pidiendo al modelo que asuma el papel de “ingeniero de prompts”. Por ejemplo, podemos instruir: “Actúa como experto en prompts y genera tres versiones mejoradas de la siguiente solicitud para que el modelo genere un plan estratégico completo: …”. El LLM responderá proponiendo diversas formulaciones de prompt y podremos seleccionar o fusionar las mejores.

Los beneficios de meta-prompting incluyen acelerar la creación de prompts y adaptarlos a contextos específicos. Según el mismo artículo, “Meta-prompting acelera el proceso de creación de prompts, permite manejar tareas complejas con mayor precisión y optimiza los prompts para modelos específicos”. En esencia, damos al modelo la capacidad de auto-evaluarse y ajustar sus instrucciones.

Ventajas clave del meta-prompting sobre few-shot tradicional:

Es más orientado a la estructura que al contenido específico. Como explica la investigación de Zhang et al. (2024), el meta-prompting se enfoca en patrones y sintaxis general para resolver problemas, en lugar de ejemplos detallados. Esto lo hace más eficiente en tokens y eficaz en escenarios nuevos: se trata de un “aprendizaje cero shots” en cierto sentido, minimizando la influencia de ejemplos concretos.

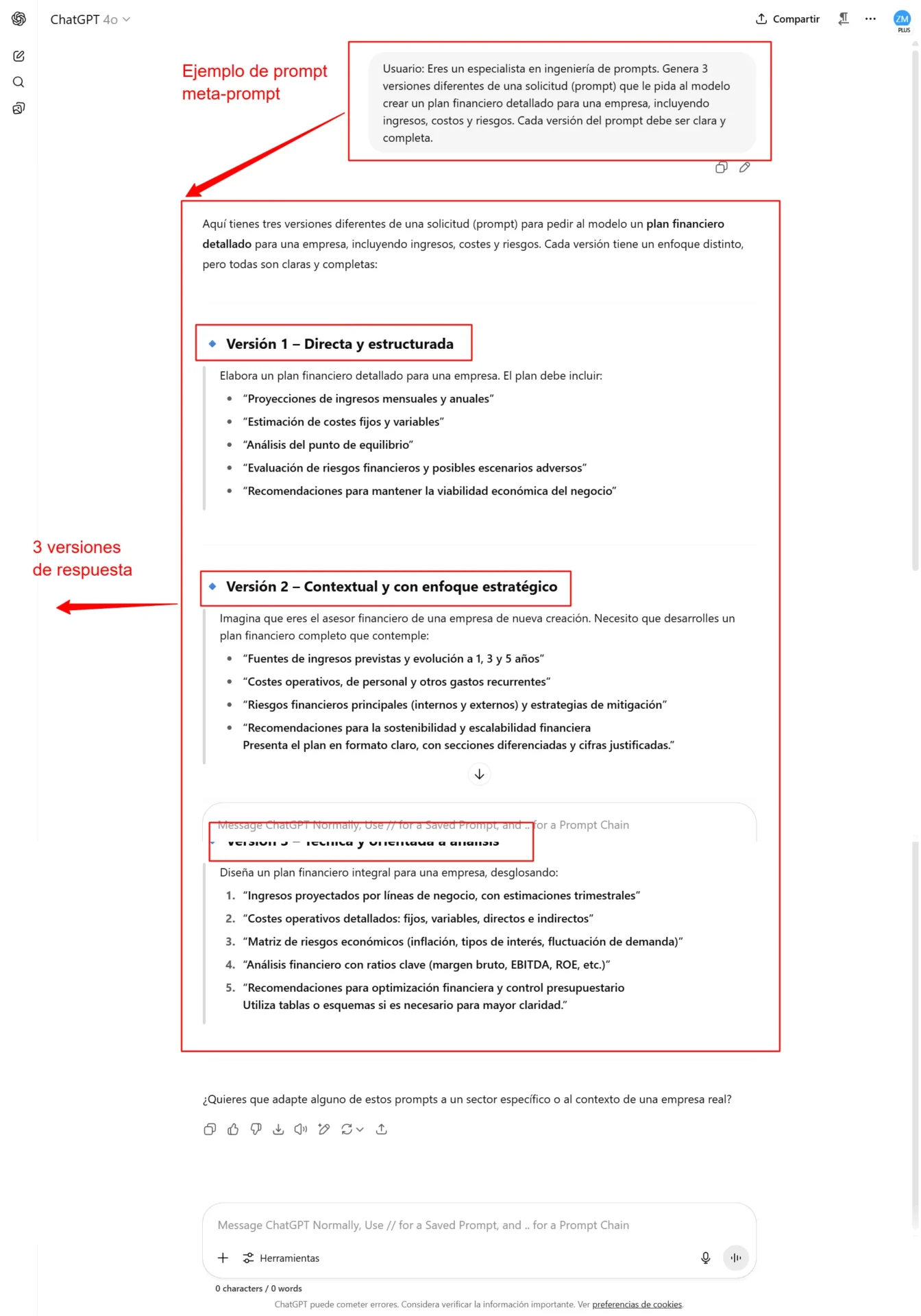

Ejemplo de de Prompt Engineering nivel PRO para meta-prompt: Imagina que queremos que el modelo redacte un presupuesto. Podemos pedirle:

Usuario: Eres un especialista en ingeniería de prompts. Genera 3 versiones diferentes de una solicitud (prompt) que le pida al modelo crear un plan financiero detallado para una empresa, incluyendo ingresos, costos y riesgos. Cada versión del prompt debe ser clara y completa.

Explicación: el modelo usaría sus conocimientos para generar varios prompts bien formulados que luego podremos usar directamente o comparar entre sí. Este proceso de iteración (generar, evaluar, refinar, iterar) se denomina método GERI en meta-prompting.

¿Listo para llevar tus prompts al siguiente nivel?

En ZeroMoment llevamos meses aplicando estas técnicas en proyectos reales: frameworks estratégicos, análisis de mercados, planes de acción completos generados con IA.

🔧 Si quieres implementar Prompt Engineering nivel PRO en tu empresa o necesitas ayuda para diseñar prompts que realmente generen impacto…

¿Charlamos? 😎

o

Si todavía no estás interesado, sigue leyendo, a ver si te convences 😉

Otras técnicas avanzadas y recomendaciones de Prompt Engineering nivel PRO

Además de las anteriores técnicas de Prompt Engineering nivel PRO, conviene conocer otras estrategias avanzadas:

- Encadenamiento de prompts (Prompt Chaining): Descomponer una tarea muy compleja en varias sub-preguntas secuenciales, alimentando la respuesta de un prompt como entrada para el siguiente. Esto crea un “flujo” de prompts que guía al modelo paso a paso (similar al CoT, pero usado cuando dividir la tarea en distintos prompts es más natural).

- Self-Consistency (Autoconsistencia): Generar múltiples cadenas de pensamiento y elegir la respuesta que se repite más entre ellas, para obtener robustez.

- Few-shot avanzado: Incluir ejemplos explicativos (no sólo ejemplos de entrada-salida) o demostrar procesos de trabajo intermedios dentro de los ejemplos, combinando CoT con few-shot.

- Ajuste de temperatura y parámetros: En nivel PRO, es útil ajustar hiperparámetros del modelo (ej. temperatura baja para respuestas más deterministas) y experimentar con prompts de sistema para controlar creatividad y detalle.

Ejemplos prácticos avanzados de Prompt Engineering nivel PRO

A continuación presentamos ejemplos concretos de prompts aplicados a contextos estratégicos. Estos escenarios muestran cómo combinar las técnicas vistas para resolver problemas de consultoría y toma de decisiones.

Caso 1 de de Prompt Engineering nivel PRO: Asesoría estratégica empresarial. Queremos que el LLM nos ayude a definir un plan de expansión para una empresa tecnológica.

Prompt:

- Sistema: Eres un consultor estratégico con 20 años de experiencia en el sector tecnológico y en mercados internacionales.

- Usuario: Nuestra empresa de software enfocada en inteligencia artificial planea expandirse a nuevos mercados globales. Analiza paso a paso los factores clave para la expansión (economía, competencia, regulación, etc.) y propone un plan estratégico en fases. Explica tu razonamiento en cada paso.

Explicación: Este prompt utiliza mensajes de sistema para fijar el rol (“consultor estratégico”) y cadena de pensamiento al pedir “explica tu razonamiento en cada paso”. Así, el modelo tenderá a detallar factores uno a uno. Se induce a un formato de análisis estructurado, ideal para planificación consultiva.

Caso 2 de de Prompt Engineering nivel PRO: Toma de decisiones comparativa. Necesitamos evaluar opciones de inversión.

Prompt:

- Sistema: Eres un analista financiero de alto nivel especializado en startups tecnológicas.

- Usuario: Compara las tres opciones de financiamiento (capital semilla, préstamo bancario, inversión ángel) para nuestra startup. Primero, explica en detalle los pros y contras de cada opción paso a paso. Luego, recomenda la mejor opción para nosotros. Usa ejemplos numéricos hipotéticos.

Explicación: Aquí se combina few-shot implícito (el usuario pide un desglose detallado) con CoT (“explica en detalle los pros y contras paso a paso”). El modelo debe razonar comparativamente. También se le brinda el rol con el mensaje de sistema. Al final, el prompt guía al modelo a entregar un análisis estructurado con conclusiones claras, útil para la toma de decisiones.

Caso 3 de Prompt Engineering nivel PRO: Generación de un framework estratégico.

Necesitamos crear una herramienta analítica (por ejemplo, un nuevo tipo de matriz de evaluación).

Prompt:

- Usuario: Actúa como un arquitecto de frameworks de negocio. Crea una nueva matriz de análisis comparativa para evaluar alianzas estratégicas de una empresa. Primero, diseña la estructura de la matriz explicando cada dimensión. Luego da un ejemplo de cómo llenar la matriz con datos ficticios para una alianza.

Explicación: Este prompt emplea meta-prompting implícito al pedir al modelo que diseñe un framework. Se solicita un proceso de diseño (estructura) antes de un ejemplo aplicado. El modelo deberá “inventar” la matriz (nuevas columnas/filas) y luego demostrarse con ejemplos. Esto lleva al modelo a actuar como generador de frameworks, una tarea avanzada donde combina capacidad creativa con estructuración lógica.

Estas muestras demuestran cómo se pueden fusionar técnicas profesionales de Prompt Engineering nivel PRO: desde especificar roles claros, hasta guiar el razonamiento interno y utilizar al modelo mismo como ayudante (p.ej., en la creación de frameworks). En cada caso, la clave está en ser específico, estructurado y aprovechar el conocimiento y capacidades del modelo mediante instrucciones avanzadas.

¿Y si tus prompts pensaran mejor que tu competencia?

Dominar el Prompt Engineering nivel PRO no es solo una ventaja técnica: es una palanca estratégica. Las técnicas que has descubierto en esta guía permiten transformar modelos de lenguaje en auténticos asistentes de consultoría, capaces de generar marcos, tomar decisiones argumentadas y resolver tareas complejas con precisión.

Si te interesa aplicar estos enfoques de forma real en tu empresa, desde ZeroMoment podemos ayudarte a diseñar prompts avanzados adaptados a tus necesidades. Estrategia, tecnología y negocio alineados con inteligencia artificial.

Pide una sesión de trabajo con nuestro equipo.

o