Contenidos

Introducción al Prompt Engineering

En la Guía básica de prompt engineering abordamos los fundamentos de cómo comunicarnos eficazmente con modelos de lenguaje. Aprendimos que un prompt (la instrucción o pregunta que le damos a la IA) debe redactarse con especificidad y claridad, dos principios fundamentales que guían al modelo hacia la respuesta deseada evitando ambigüedades.

Por ejemplo, vimos la importancia de indicar con precisión lo que buscamos en el prompt engineering. De esta manera, veíamos que usando tecnicas báscias de Propmt engineering, se mejoraba el formato de respuesta esperado y se destapaba la necesidad de proporcionar contexto profundo o ejemplos simples cuando fuera necesario. Estos cimientos sentaron las bases para obtener resultados útiles de la IA en consultas directas y relativamente sencillas.

Ahora, ¿por qué avanzar a un nivel intermedio? A medida que planteamos tareas más complejas o especializadas, las técnicas básicas de prompt engineering pueden quedarse cortas. Situaciones del mundo real —como análisis de datos extensos, generación de código funcional o creación de contenido optimizado para SEO— requieren un control más fino sobre las respuestas de la IA. La guías básica no enseñó lo qué es un buen prompt; esta pequeña guía intermedia se enfoca en cómo llevar esos prompts al siguiente nivel para obtener respuestas más precisas, contextualizadas y útiles.

Aí pues, repasaremos brevemente los conceptos clave del nivel básico para contextualizar al lector, y luego introduciremos técnicas de prompt engineering avanzado. Exploraremos el Role Prompting (asignar un rol o personalidad a la IA) y cómo cambia sus respuestas; discutiremos la provisión de contexto avanzado, distinguiendo entre dar información general versus específica; y profundizaremos en el refinamiento iterativo con feedback, mostrando cómo mejorar las respuestas mediante ajustes sucesivos y autoevaluación de la IA. Finalmente, aplicaremos todo esto en tres ejemplos prácticos (análisis de datos, generación de código y optimización SEO) para ver las técnicas en acción.

El tono será didáctico y accesible, incrementando el tecnicismo solo cuando sea necesario, de modo que puedas seguir progresando de la teoría básica a la aplicación intermedia del prompt engineering avanzado. Con estos objetivos en mente, continuemos nuestro viaje hacia un manejo más avanzado de los prompts, construyendo sobre lo aprendido previamente y desbloqueando interacciones con IA más sofisticadas y efectivas.

Role Prompting en prompt engineering: Enseñando a la IA a responder como un experto

Una de las técnicas avanzadas más poderosas del prompt engineering es el Role Prompting, o asignación de un rol a la IA. Consiste en indicarle al modelo que asuma la identidad, perspectiva o estilo de un experto específico antes de responder. En esencia, es como si en lugar de interactuar con un asistente genérico, lo situáramos en el papel de, por ejemplo, un doctor, un desarrollador senior o un profesor especializado en cierta materia. ¿El resultado? Respuestas más especializadas en contenido y adaptadas en tono y vocabulario a ese rol definido.

¿Qué beneficios tiene el Role Prompting y por qué es útil en el contexto del prompt engineering? Al asignar un rol, establecemos un marco de referencia que ayuda a la IA a filtrar y priorizar la información relevante para ese papel, adoptar el vocabulario y tono apropiados, y proporcionar respuestas más contextualizadas y especializadas.

Por ejemplo, si la IA “piensa” como médica, dará explicaciones con términos clínicos y consideraciones de salud; si actúa como analista financiero, enfocará su respuesta en datos y tendencias económicas. Esta técnica del Prompt Engineering de nivel avanzado, explota la capacidad del modelo para adaptar su «personalidad» y conocimientos al contexto que le indiquemos. Un estudio de OpenAI en 2023 incluso encontró que las respuestas generadas con Role Prompting fueron valoradas como un 42 % más precisas y útiles en comparación con prompts genéricos, evidenciando cuánto puede mejorar la calidad de la respuesta con solo definir un rol adecuado.

Veamos la diferencia entre un prompt sin rol y un prompt con rol definido. Imagina que estamos pidiendo consejo para mejorar un programa de computación con prompt engineering:

- Prompt sin rol:

“¿Cómo puedo mejorar mi código?”

- Respuesta (sin rol): Posiblemente la IA dará sugerencias generales de buenas prácticas de programación, pero sin un foco específico, tal vez mencione cosas algo vagas (“refactoriza el código”, “agrega comentarios”, etc.), ya que no sabe qué tipo de mejora se busca exactamente.

Ahora apliquemos Role Prompting en Prompt Engineering, especificando el perfil del experto consultado:

- Prompt con rol definido:

“Actúa como un desarrollador de software senior con 15 años de experiencia en optimización de código. Este es un fragmento de mi código […]. ¿Qué sugerencias me darías para mejorarlo?”

- Respuesta (con rol): La IA responde adoptando ese papel experto. Por ejemplo: “Como desarrollador senior, lo primero que noto es que podrías optimizar la función X para reducir su complejidad. Te sugeriría usar un algoritmo más eficiente, quizás implementando Y en lugar de Z. Además, tus variables podrían llevar nombres más descriptivos para mejorar la legibilidad…”. Vemos que la respuesta se vuelve más profunda y específica, como un mentor experto señalando mejoras concretas y con el lenguaje técnico apropiado.

Esta diferencia es fundamental en el prompt engineering, ya que el rol permite obtener una revisión crítica y detallada, como la que daría un profesional con amplia experiencia. Definir el rol de la IA es sencillo en la práctica: suele bastar con empezar el prompt con una frase del estilo “Eres un [rol deseado]…” o “Actúa como [experto en X]…”, seguida de la pregunta o tarea. Cuanta más información proporcionemos sobre el rol, mejor.

Por ejemplo, no es lo mismo decir «Eres un chef» que indicar «Eres un chef profesional especializado en cocina mediterránea con 20 años de experiencia en restaurantes con estrella Michelin». Mientras más detallado sea el perfil (área de expertise, años de experiencia, contexto del rol), más podrá afinar la IA el tono y contenido de su respuesta acorde a esa persona ficticia.

Técnicas para definir el rol de la IA en el marco del prompt engineering a nivel avanzado:

- Indica el rol al inicio: Comienza el prompt declarando el personaje o experto deseado. Ej: «Como analista de datos de una empresa tecnológica, explica…» Esto prepara a la IA desde el primer momento.

- Añade contexto del rol si es pertinente: Puedes incluir detalles como nivel de experiencia, ámbito o incluso una misión. Ej: «Eres un abogado experto en derecho laboral, conocido por explicar conceptos complejos en términos sencillos.» De este modo, guías no solo el conocimiento sino también el estilo de la respuesta (aquí, explicar en términos sencillos).

- Mantén el rol durante la interacción con IA: Si es un diálogo con varias preguntas, no está de más reiterar o mantener el personaje. La IA tiende a conservar el rol una vez asignado, pero si la conversación se alarga, podrías recordarle: «Desde tu perspectiva de profesor, ¿qué opinas sobre…».

- Evita contradicciones entre el rol y la tarea: Por ejemplo, un rol de «experto en lenguajes formales» quizá no sea el mejor para escribir un poema emotivo. El rol debe ser relevante a la instrucción dada para obtener mejores resultados.

Por lo tanto, se puede afirmar que el Role Prompting es una técnica esencial del prompt engineering de nivel avanzado porque nos permite personalizar la voz y especialización de la IA. Es como elegir el consultor perfecto para nuestra pregunta. Un mismo modelo puede adoptar distintos papeles según lo que necesitemos. Esta personalización mejora significativamente la calidad, pertinencia y profundidad de las respuestas.

Contexto avanzado: cómo proporcionar información clave para respuestas precisas con Prompt Engineering

Además del rol, otro factor crítico en el prompt engineering para obtener buenas respuestas es el contexto que proporcionamos en el prompt. En la guía básica ya destacamos la importancia de dar detalles contextuales cuando la pregunta lo amerita –datos relevantes, condiciones del problema o información de referencia– en lugar de lanzar una pregunta al vacío. Ahora profundizaremos en cómo llevar el uso del contexto al siguiente nivel para lograr respuestas más precisas y ajustadas a nuestras necesidades.

¿Por qué es tan importante el contexto en el prompt engineering? Piensa que los modelos de lenguaje como GPT han sido entrenados con una gran cantidad de información general, pero no conocen tu situación específica a menos que se la cuentes. Proporcionar contexto es, esencialmente, poner en situación a la IA: delimitar el tema y darle los datos o antecedentes necesarios para que no deba adivinar o recurrir solo a conocimiento genérico. Un prompt con contexto adecuado ayuda al modelo a construir una comprensión más completa y matizada de lo que le pedimos, resultando en respuestas mucho más relevantes. De hecho, se ha observado que los prompts que emplean un contexto enriquecido producen respuestas significativamente más precisas y contextualizadas (según un estudio, hasta un 40% más precisas) que aquellos que proporcionan la información de manera plana o insuficiente.

En otras palabras, mientras más pertinente sea la información que incluyamos en la pregunta, mejor podrá la IA afinar su respuesta

Contexto general vs. contexto altamente específico: No todo contexto es igual. Un contexto general puede simplemente señalar el tema (ej. «haz un resumen sobre energías renovables»). En cambio, un contexto específico delimita claramente el alcance (ej. «resume cómo ha crecido la energía solar en España durante la última década, incluyendo cifras actuales»), le da al modelo una guía muchísimo más concreta de lo que debe cubrir. De esta forma, obtendremos un resumen centrado en España, energía solar y con posiblemente datos actualizados (si el modelo los tiene o si se los proporcionamos). Esta atención al detalle es clave en niveles avanzados de prompt engineering.

Proporcionar contexto específico suele implicar ofrecer información clave dentro del prompt. Esto puede tomar varias formas según la tarea:

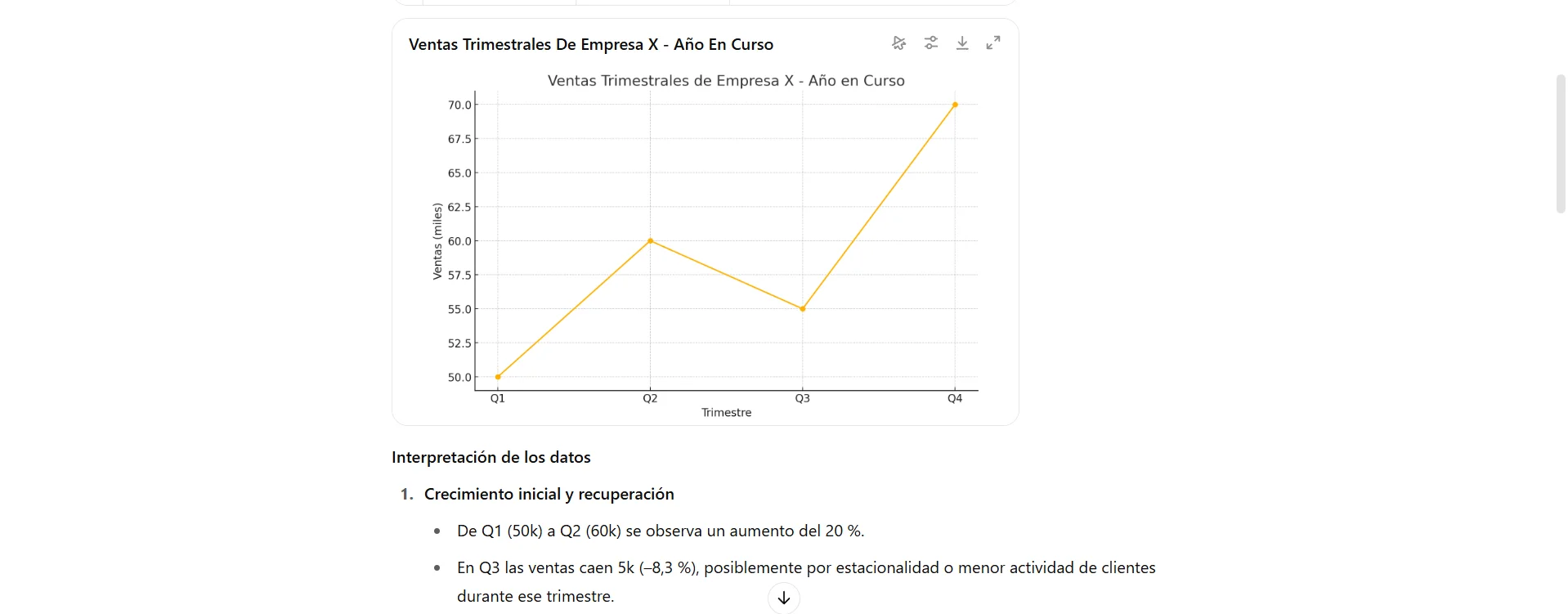

- Datos o hechos relevantes: Si queremos que la IA analice o se base en ciertos datos, debemos incluírselos. Ejemplo: «Dado el siguiente registro de ventas trimestrales: Q1=50k, Q2=60k, Q3=55k, Q4=70k, ¿qué tendencias de ventas observas este año?». Sin esos números, el modelo no puede saber nuestras ventas; con los datos entregados, puede hacer cálculos o inferencias correctas sobre tendencias.

- Contexto situacional o de dominio: Por ejemplo, «Estoy desarrollando una aplicación móvil de finanzas personales. ¿Qué consideraciones de seguridad debo tener?». Aquí le indicamos a la IA el dominio (app móvil financiera) y la tarea (consideraciones de seguridad), para obtener consejos relevantes a ese escenario, en vez de recomendaciones genéricas sobre desarrollo.

- Instrucciones de enfoque o limitaciones: A veces el contexto no son datos adicionales, sino aclaraciones de qué queremos o no queremos en la respuesta. Ejemplo: «Escribe una reseña de este producto. Contexto: es un gadget dirigido a niños, enfócate en la perspectiva de un padre y no menciones detalles técnicos complicados.» Estamos estableciendo el contexto de audiencia (padres, niños) y orientación de la respuesta.

Estructurar un prompt con contexto detallado también es una habilidad esencial del prompt engineering. Una buena práctica es organizar la información de forma clara antes de la pregunta principal. Así se evita confundir al modelo o recibir respuestas poco enfocadas.

A estos niveles, en prompt engineering ya podemos y deberíamos pensar en el «prompt» como si fuera un pequeño briefing:

- Introducir el escenario o datos relevantes: primero suministramos a la IA la información de base que necesita. Puede ser un párrafo, una lista de puntos, datos tabulares resumidos, texto de referencia, etc.

- Formular la solicitud o pregunta concreta: después de darle los datos, le pedimos lo que queremos que haga con ellos (analizar, resumir, resolver, opinar, etc.). Incluso podemos emplear conectores como «Con base en lo anterior…» o «Dado ese contexto, ahora…» para dejar claro que la pregunta debe responderse usando lo proporcionado.

Formular la solicitud o pregunta concreta: después de darle los datos, le pedimos lo que queremos que haga con ellos (analizar, resumir, resolver, opinar, etc.). Incluso podemos emplear conectores como «Con base en lo anterior…» o «Dado ese contexto, ahora…» para dejar claro que la pregunta debe responderse usando lo proporcionado.

Eres un asesor de marketing digital.

Contexto: La empresa XYZ lanzó un nuevo producto hace 3 meses pero las ventas han sido bajas. Invirtieron mucho en redes sociales pero casi nada en SEO.

Pregunta: ¿Qué estrategias recomendarías para mejorar las ventas en el próximo trimestre?

Este prompt aplica Role Prompting más contexto específico, y el resultado será una respuesta enfocada en las causas del problema y sugerencias adecuadas. Es un ejemplo clásico del prompt engineering, donde el modelo trabaja con una base sólida y bien definida. Aquí tenemos Role Prompting (asesor de marketing) más contexto específico (datos sobre el lanzamiento, las ventas bajas y la distribución de inversión publicitaria), seguido de la tarea. Una respuesta de la IA a este prompt probablemente abordará justamente esos detalles: quizás sugerirá mejorar SEO dado que está descuidado, ajustar la estrategia en redes sociales, etc., en lugar de listar tácticas genéricas de marketing.

Es importante destacar la diferencia con un prompt sin contexto o con contexto pobre. Si solo hubiéramos preguntado «¿Cómo aumento las ventas de un producto nuevo?«, la IA daría ideas generales aplicables a cualquier producto. Al agregar el contexto de la situación real, obtenemos consejos adaptados a esa empresa en particular.

¿Cómo distinguir información útil de ruido? Al aportar contexto avanzado, debemos enfocarnos en la información clave que realmente influirá en la respuesta. Incluir datos irrelevantes o exceso de texto puede confundir al modelo o diluir el foco. Cada pieza de contexto que sumemos debe aportar valor a la comprensión de la solicitud

Por ejemplo, si queremos un diagnóstico médico basado en síntomas, proporcionaremos los síntomas, antecedentes y duración, pero no hará falta contar toda la historia de vida del paciente. Del mismo modo, si pedimos optimización de código, incluiríamos el código en cuestión y quizá el mensaje de error o comportamiento esperado, pero no es necesario añadir información de otras partes del programa que no estén relacionadas. Contexto avanzado no significa escribir prompts larguísimos indiscriminadamente, sino ser estratégicos con el prompt engineering: dar suficiente detalle para orientar la respuesta sin abrumar con datos innecesarios.

Resumiendo, al proporcionar un contexto rico y específico en nuestros prompts, habilitamos al modelo para que entregue respuestas más acertadas y útiles. La IA “entiende” mejor lo que necesitas porque la has situado en el escenario correcto. Esta técnica de prompt engineering combinada con Role Prompting, logra que el modelo actúe como un experto dentro de un marco concreto, llevando la calidad de la respuesta a un nivel superior. En la siguiente sección veremos que, aun con buen rol y contexto, a veces hace falta refinar más las cosas; por eso abordaremos ahora cómo iterar y pulir las respuestas de la IA mediante feedback.

Prompt Engineering para refinamiento basado con en iteración y feedback

Refinamiento basado en iteración y feedback

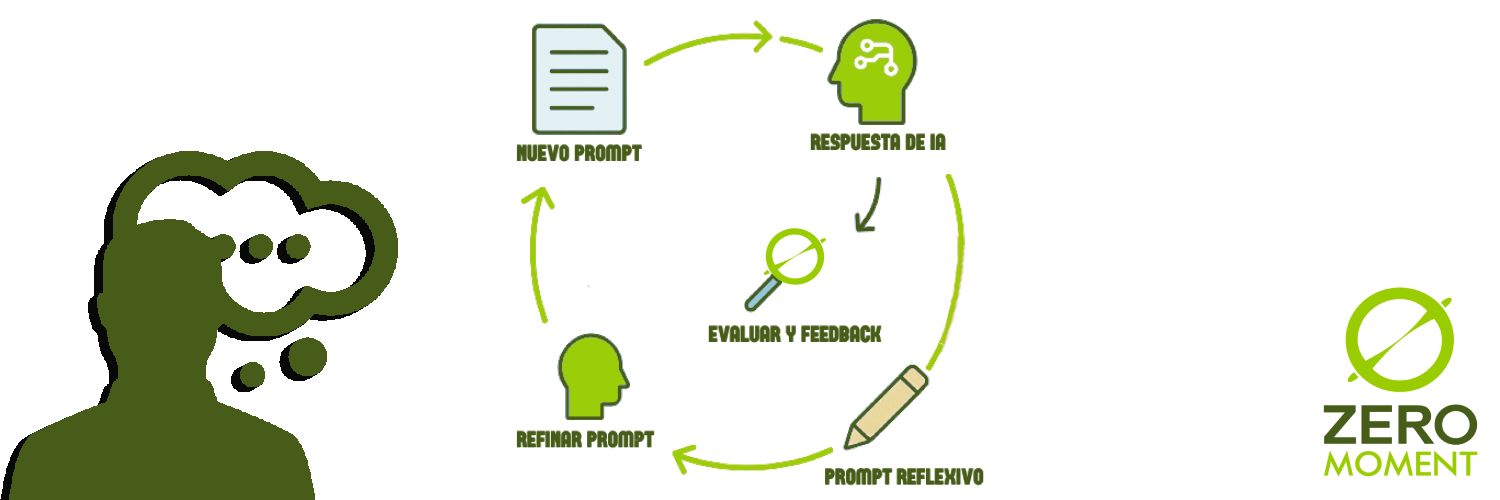

Incluso con un buen prompt inicial, es común que la primera respuesta de la IA no sea perfecta o exactamente lo que esperábamos. La ingeniería de prompt engineering es un proceso iterativo por naturaleza: rara vez obtenemos la respuesta ideal al primer intento, especialmente en consultas complejas. Adoptar una mentalidad de prueba y ajuste continuo es clave para dominar esta habilidad.

En esta sección, en la que hablaremos del prompt engineering, veremos por qué los prompts se benefician de la iteración, métodos para mejorar las respuestas mediante ajustes progresivos y cómo podemos involucrar a la propia IA en la revisión de sus respuestas (feedback autogenerado).

¿Por qué los prompts rara vez son perfectos de entrada? Principalmente porque nuestro enunciado inicial puede omitir detalles, tener ambigüedades que no detectamos al formularlo, o simplemente porque la tarea es compleja y la IA necesita un poco más de guía. Al ver la primera respuesta, podemos identificar qué faltó o qué salió mal: tal vez la respuesta fue demasiado superficial, o se desvió del tema en cierta parte, o no presentó la información en el formato deseado. En lugar de frustrarnos, podemos ver la primera interacción con IA como un borrador sobre el cual iterar.

Estos son algunos de los métodos utilizados en el Prompt Engineering para mejorar las respuestas mediante ajustes progresivos:

- Ajustar el prompt e intentarlo de nuevo: Es la forma más directa. Si notamos que la respuesta se quedó corta en algún aspecto, podemos aclararlo en el siguiente prompt. Por ejemplo, si la respuesta fue genérica, en la siguiente iteración pedimos más detalle; si omitió cierta sección, añadimos explícitamente «incluye X en la respuesta«; si estuvo confusa, solicitamos más claridad. Cada iteración incorporamos las lecciones aprendidas de la anterior. Imaginemos que inicialmente preguntamos: «Dame recomendaciones para mejorar mi sitio web«. Supongamos que la respuesta de la IA nos dio consejos técnicos, pero ninguno sobre contenidos. Podemos refinar el prompt: «Dame recomendaciones para mejorar mi sitio web, especialmente en el aspecto de contenido y SEO.» Con este ajuste, es probable que la siguiente respuesta cubra ese ángulo que antes faltó.

- Usar preguntas de seguimiento: En un entorno conversacional, a veces no es necesario reescribir todo el prompt; podemos simplemente preguntar algo más o pedir una modificación sobre la respuesta dada. Por ejemplo: «Buen aporte, ¿podrías profundizar en el segundo punto?» o «¿Puedes dar un ejemplo concreto de lo que mencionaste?«. Esta estrategia aprovecha la memoria de la conversación: la IA recuerda lo que acaba de generar y sobre eso mismo elabora más. Es una forma de iterar sin empezar de cero, afinando gradualmente la respuesta hasta que tenga el nivel de detalle o claridad deseado.

- Experimentar con enfoques distintos: Si tras un par de iteraciones la respuesta no va por el camino correcto, quizás el prompt necesite un replanteamiento más grande. Podemos intentar enfocar la pregunta de otra manera, usar una analogía, o incluso probar una técnica diferente (por ejemplo, proporcionar un ejemplo de la respuesta que buscamos, cambiar el rol asignado, etc.). La iteración no solo corrige pequeños fallos, a veces implica pivotar la estrategia de prompt hasta hallar la que mejor funcione.

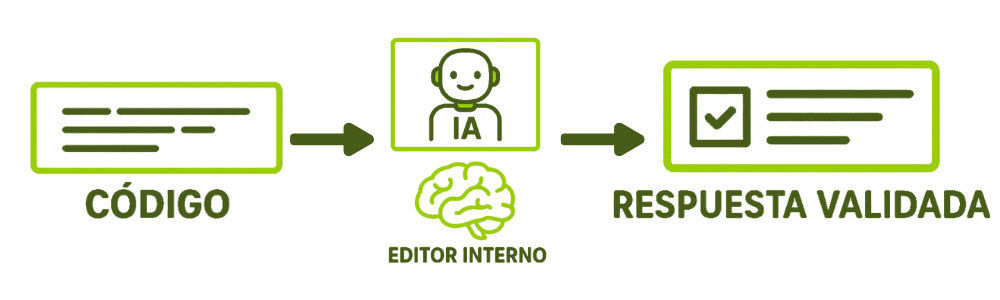

Un aspecto muy interesante del refinamiento iterativo en prompt engineering, es que podemos involucrar al propio modelo en la mejora de sus respuestas. Es decir, solicitar a la IA que evalúe y refine lo que ella misma respondió. Esto suena casi paradójico, pero en la práctica es una técnica avanzada conocida como Reflexive Prompting o autoevaluación de la IA. Consiste en pedirle al modelo que, antes de dar la respuesta final, inspeccione críticamente su respuesta provisional, buscando errores, omisiones o mejoras posibles

En cierto modo, es como tener un editor interno en la IA que revisa el contenido. Estudios indican que incorporar este paso de auto-revisión puede aumentar significativamente la calidad y exactitud de las respuestas (un laboratorio de IA de Stanford reportó hasta un 40% de mejora en precisión con respecto a métodos tradicionales sin autoevaluación).

¿Cómo podemos aplicar esto a través del prompt engineering? Hay un par de formas:

- En un solo prompt complejo: Estructuramos la petición para que el modelo primero genere una respuesta inicial y luego la re-evalúe. Por ejemplo: «Por favor, resuelve el siguiente problema y luego revisa críticamente tu solución: [planteamiento]. Da primero tu respuesta, y a continuación analiza si pudiste cometer algún error o pasar algo por alto, corrigiéndolo si es necesario.» Con este tipo de indicación, la IA podría responder con algo así como: «Respuesta inicial: …; Revisión: Tras analizar mi resultado, me doy cuenta de que … Por lo tanto, la respuesta ajustada sería …». Estamos básicamente pidiéndole que piense dos veces antes de concluir.

- Como paso separado después de una respuesta: Esta es más fácil en interacción. Primero hacemos la pregunta normalmente, obtenemos una respuesta, y luego damos una instrucción de feedback: «Revisa tu respuesta e identifica si falta abordar algún requisito de mi pregunta. Si es así, mejora la respuesta.» o «¿Es tu respuesta suficientemente detallada y correcta? Si no, por favor refine la respuesta.«. La IA tomará su propia respuesta como base, la cotejará contra lo que le pedimos originalmente (gracias a que mantiene el historial del chat) y producirá una versión mejorada.

Por ejemplo, supongamos que la IA nos dio una explicación técnica algo complicada. Podríamos responderle: «Ahora, por favor, vuelve a explicar lo anterior asegurándote de que sea comprensible para un principiante y corrigiendo cualquier posible imprecisión.» La IA entonces reinterpretará su explicación con un lenguaje más sencillo y corregirá detalles, cumpliendo con el nuevo criterio que le indicamos.

Este proceso de iteración y feedback puede repetirse varias veces. Cada ciclo idealmente nos acerca más a la respuesta perfecta. Sin embargo, hay que saber cuándo parar: a veces, la IA puede empezar a divagar o a sobre-corrigir si le pedimos revisión tras revisión. Un exceso de autoevaluación podría generar respuestas redundantes o demasiado cautelosas.

Lo importante es lograr un equilibrio: iterar lo suficiente para pulir la respuesta, pero sin llegar a enredar al modelo en una reflexión interminable.

En la práctica, muchas conversaciones efectivas con IA siguen este patrón iterativo: se hace una pregunta inicial, luego una serie de afinaciones. Lejos de ser un signo de mal prompt, esta iteración es esperable y forma parte del flujo de trabajo de un ingeniero de prompts. Adoptar este hábito de refinar continuamente (incluso aprovechando el feedback de la IA hacia sí misma) nos permite obtener resultados más sólidos. Al final, el objetivo es que la respuesta final cumpla con todos nuestros criterios: que sea correcta, completa, bien enfocada y presentada en el formato o estilo que necesitamos.

Habiendo cubierto las técnicas avanzadas (rol, contexto y refinamiento iterativo), pasemos a lo más ilustrativo: ejemplos prácticos. A continuación, aplicaremos estos conceptos en tres escenarios concretos para ver cómo se construyen prompts intermedios y qué diferencia logran frente a enfoques más básicos.

Ejemplos prácticos en áreas específicas con Prompt Engineering

En esta sección desarrollaremos el Prompt Engineering a nivel mayores, mediante tres ejemplos prácticos de prompts en contextos distintos: análisis de datos, generación de código y optimización de SEO. En cada caso, compararemos un enfoque básico de prompt con una versión mejorada aplicando Role Prompting, contexto detallado y refinamiento según convenga. Veremos cómo estas técnicas avanzadas se traducen en respuestas de mayor calidad y utilidad.

Ejemplo 1: Análisis de datos con Prompt Engineering

Supongamos que tenemos un conjunto de datos simples sobre ventas trimestrales de una empresa y queremos que la IA nos ayude a interpretarlos. Un enfoque básico podría ser simplemente pedir el análisis directamente:

- Prompt básico:

«Analiza las siguientes cifras de ventas trimestrales: Q1 = 50k, Q2 = 60k, Q3 = 55k, Q4 = 70k.»

- Respuesta del modelo (básica): «Las ventas aumentaron de 50k en el primer trimestre a 60k en el segundo trimestre. En el tercer trimestre hubo una ligera caída a 55k, pero luego volvieron a subir a 70k en el cuarto trimestre. En general, las ventas muestran una tendencia al alza a lo largo del año.»

La respuesta básica no está mal: describe los datos y señala la tendencia general. Sin embargo, es puramente descriptiva y bastante superficial —algo que cualquiera podría deducir de mirar los números. No ofrece interpretación ni recomendaciones.

Ahora veamos cómo un prompt intermedio mejorado puede obtener más valor añadido. Aplicaremos Role Prompting (queremos que responda como un analista de datos experto) y daremos más contexto de lo que buscamos (por ejemplo, identificar tendencias y sugerir acciones):

- Prompt mejorado (con rol y contexto):

«Eres un analista de datos experimentado en ventas corporativas. A continuación te proporciono las ventas trimestrales de este año de la Empresa X: Q1 = 50k, Q2 = 60k, Q3 = 55k, Q4 = 70k. Necesito que interpretes estos datos, identificando tendencias importantes y proporcionando recomendaciones para el próximo año basadas en el patrón de ventas.»

Aquí hemos definido un rol claro («analista de datos experimentado en ventas corporativas») y añadido la instrucción de que, además de interpretar, dé recomendaciones. Veamos cómo podría responder la IA:

- Respuesta del modelo (mejorada): «Como analista de datos de ventas, lo primero que observo es una tendencia general ascendente en las ventas a lo largo del año. Hay un incremento notable del 20% de Q1 a Q2, luego una leve caída (~8%) en Q3, seguida por un fuerte repunte del 27% en Q4. Esta caída en el tercer trimestre podría deberse a factores estacionales (por ejemplo, menor demanda en verano) o a alguna incidencia específica que habría que investigar¨.

De cara al próximo año, recomendaría: (1) Analizar en detalle el motivo de la caída en Q3 – si fue estacional, podríamos planificar promociones en ese periodo para mitigarla; (2) Capitalizar el impulso de Q4 – quizás hubo una campaña exitosa o un aumento por la temporada navideña, valdría la pena replicar estrategias similares en Q4 del año siguiente; (3) Revisar los recursos de ventas del primer semestre – dado que el mayor crecimiento ocurrió temprano (Q1 a Q2), asegurarse de que marketing y stock estén preparados para sostener ese crecimiento.

En resumen, las ventas anuales de Empresa X crecieron con un pequeño bache a mitad de año. La recomendación es investigar la causa de la caída en Q3 y reforzar las estrategias que funcionaron bien en Q2 y Q4 para mantener un crecimiento sostenido.»

Notemos la diferencia. La respuesta con el prompt mejorado no solo enuncia los números, sino que ofrece un análisis interpretativo (posible causa estacional para la caída de Q3) y sugerencias accionables. El tono es el de un profesional que brinda un informe ejecutivo. Este valor añadido provino de un prompt más elaborado que le indicó al modelo qué papel tomar y qué enfoque dar a la respuesta (identificar tendencias + recomendaciones).

Si la respuesta aún no fuera satisfactoria, podríamos iterar: por ejemplo, si queremos más detalle sobre un punto, pedir:

«¿Podrías cuantificar el crecimiento total anual en porcentaje?» o «Elabora más la recomendación sobre promociones en Q3«.

La IA, recordando el contexto proporcionado, ajustaría su respuesta según la petición adicional.

Este ejemplo muestra cómo, con técnicas intermedias, pasamos de una simple descripción de datos a un análisis contextualizado con asesoramiento, simulando la voz de un experto humano.

Ejemplo 2: Generación de código con Prompt Engineering

En este caso, necesitamos que la IA nos ayude a escribir código. Supongamos que queremos una función en Python para generar la secuencia de Fibonacci. Un usuario novato podría simplemente pedir:

- Prompt básico: «Escribe una función en Python que calcule la serie de Fibonacci.»

La IA probablemente devolverá una implementación válida, pero quizá no la más eficiente, o sin explicaciones. Por ejemplo, podría dar algo así:

“python

def fibonacci(n):

if n <= 1:

return n

else:

return fibonacci(n-1) + fibonacci(n-2)

“

Esta respuesta básica cumple con lo pedido (calcula Fibonacci) pero tiene algunos detalles mejorables: usa una solución recursiva simple que es ineficiente para n grandes (complejidad exponencial), y no incluye ningún comentario o explicación.

Pasemos a un prompt intermedio mejorado. Aplicaremos Role Prompting para que la IA responda como una desarrolladora experta, y especificaremos requisitos más detallados en el contexto:

- Prompt mejorado (con rol y detalles): «Eres una desarrolladora senior experta en Python. Necesito una función en Python que calcule la serie de Fibonacci de forma eficiente (complejidad temporal O(n)). Por favor, proporciona el código con buenas prácticas, incluyendo comentarios explicativos y manejo de posibles errores de entrada (por ejemplo, si el argumento no es válido).»

Con este prompt, esperamos una solución optimizada, bien documentada y robusta. Una posible respuesta mejorada de la IA sería:

“

python

def fibonacci(n):

«»»

Calcula el n-ésimo número de la serie de Fibonacci de forma eficiente.

Utiliza un enfoque iterativo para lograr complejidad O(n).

«»»

# Validación de la entrada

if not isinstance(n, int) or n < 0:

raise ValueError(«El argumento debe ser un entero no negativo»)

# Caso base

if n < 2:

return n

# Cálculo iterativo de Fibonacci

a, b = 0, 1

for _ in range(2, n + 1):

a, b = b, a + b

return b

“

Comentarios de la IA: Esta implementación utiliza un bucle for para iterar hasta n, calculando de manera acumulativa el siguiente número Fibonacci a partir de los dos anteriores (a y b). De este modo evitamos la explosión combinatoria de la recursividad. También se incluye una comprobación de tipo y valor al inicio para asegurarnos de que la función recibe un entero no negativo, lanzando una excepción en caso contrario, lo cual hace la función más robusta ante entradas incorrectas.

Observamos que la IA, actuando como desarrolladora senior, entregó código con características profesionales: es iterativo (O(n) en tiempo), tiene comentarios y documentación, y contempla validación de la entrada. Todo esto se alineó con el contexto detallado proporcionado en el prompt. Si hubiéramos mantenido la solicitud vaga, no habríamos obtenido este nivel de calidad.

Vale la pena mencionar que, si por alguna razón el código generado aún no fuera perfecto (imaginemos que olvidó algún detalle, o queremos que también incluya pruebas unitarias), podríamos iterar con feedback. Por ejemplo:

«Gracias, ¿podrías agregar un pequeño ejemplo de uso de la función en los comentarios?» o «¿Puedes incluir también una breve explicación de la complejidad espacial de tu solución?«.

Dado que la IA entiende el código que produjo, sería capaz de agregar esas partes en una siguiente respuesta, refinando el resultado.

Este ejemplo de generación de código muestra cómo un prompt intermedio bien formulado puede guiar a la IA a producir código más utilizable en un entorno real, y no solo resolver el problema de forma mínima. Es como pasar de pedirle a un estudiante que resuelva un ejercicio, a pedirle a un ingeniero que implemente una solución lista para producción, con buenas prácticas.

Ejemplo 3: Optimización de SEO con Prompt Engineering

Para nuestro tercer escenario, consideremos la generación de contenido optimizado para motores de búsqueda (SEO). Supongamos que queremos un artículo sobre la importancia de la ciberseguridad, orientado a pequeñas empresas, y optimizado para SEO con ciertas palabras clave. Un prompt básico podría ser demasiado genérico:

- Prompt básico:

«Escribe un artículo sobre la importancia de la ciberseguridad.»

La IA generará posiblemente un artículo correcto sobre el tema, pero sin una dirección específica: podría hablar en términos muy generales, no necesariamente enfocados en pequeñas empresas, y probablemente no estará afinado para SEO (por ejemplo, puede que no incluya las palabras clave que nos interesan, ni una estructura con subtítulos atractivos).

Pasemos a un prompt intermedio mejorado, donde definiremos un rol y daremos instrucciones precisas para SEO:

- Prompt mejorado (con rol y contexto SEO):

«Eres un especialista en SEO y marketing de contenidos. Necesito un artículo sobre la importancia de la ciberseguridad en las pequeñas empresas, de aproximadamente 1000 palabras. Debe estar optimizado para SEO: incluye de forma natural las siguientes palabras clave objetivo: ‘seguridad informática’, ‘protección de datos’, ‘amenazas cibernéticas’. Además, estructura el artículo con subtítulos descriptivos (H2 o H3) que aborden distintos aspectos (por ejemplo: vulnerabilidades comunes, buenas prácticas, beneficios de invertir en ciberseguridad). Al final, añade una conclusión sólida y un llamado a la acción. También proporciona una meta descripción atractiva de unas 155 caracteres para el artículo.»

Este es un prompt bastante detallado: establece el rol (especialista SEO), define el tema con un ángulo específico (ciberseguridad en pymes), indica la longitud aproximada, las keywords a incluir, cómo estructurar (subtítulos, conclusión, CTA) e incluso pide la meta descripción. Con todas estas indicaciones, la IA tiene un plano claro de lo que debe entregar.

¿Cuál sería el resultado? En lugar de reproducir las ~1000 palabras, describamos los puntos clave que probablemente contendrá la respuesta de la IA:

- Un título SEO-friendly que incluya el tema, por ej.: «La importancia de la ciberseguridad en las pequeñas empresas: protegiendo datos frente a amenazas cibernéticas» (noten que ya hay palabras clave ahí).

- Una introducción que contextualiza el problema (pymes frecuentemente subestiman la seguridad informática, etc.) y quizás menciona brevemente por qué la ciberseguridad es crucial.

- Varios subtítulos (H2/H3) segmentando el contenido, por ejemplo:

- «Vulnerabilidades comunes en pequeñas empresas» – donde hable de ataques típicos que sufren (phishing, malware) usando el término amenazas cibernéticas.

- «Protección de datos: salvaguardando la información sensible» – discutiendo cómo una brecha afecta datos de clientes, etc., incluyendo la frase protección de datos.

- «Beneficios de invertir en seguridad informática» – destacando ventajas concretas (evitar pérdidas económicas, confianza de clientes), usando la keyword seguridad informática.

- «Buenas prácticas de ciberseguridad para Pymes» – una lista de recomendaciones (usar antivirus, formación empleados, backups, etc.).

- «Vulnerabilidades comunes en pequeñas empresas» – donde hable de ataques típicos que sufren (phishing, malware) usando el término amenazas cibernéticas.

- Un párrafo de conclusión que resuma la idea principal (la ciberseguridad es una inversión necesaria, etc.) e incluya un llamado a la acción, por ejemplo invitando a los dueños de pymes a auditar su seguridad o a leer más recursos, o contactarnos si es un caso de una empresa ofreciendo servicios.

- La meta descripción solicitada, algo como: «Descubre por qué la ciberseguridad es clave para las pequeñas empresas. Aprende a proteger tus datos y prevenir amenazas cibernéticas con estas buenas prácticas.» (aprox 150 caracteres, concisa y atractiva, incorporando también palabras clave).

La respuesta de la IA, con alta probabilidad, cumpliría con todos esos puntos porque el prompt los enumeró claramente. Estaríamos obteniendo un borrador de artículo listo para usar o con mínima edición: optimizado con keywords, bien estructurado y con los elementos esenciales para SEO (encabezados ricos en contenido, conclusión con CTA, meta descripción).

Si la IA omitiera algo (imaginemos que olvidó la meta descripción al final), simplemente podríamos recordárselo: «Por favor añade la meta descripción de ~155 caracteres que faltó.«, y lo haría en un turno siguiente. O si algún subtítulo no nos convence, podríamos pedirle que lo reformule. Pero gracias a la especificidad del prompt, es muy posible que la primera respuesta ya venga completa.

Este ejemplo ilustra cómo un prompt exhaustivo y bien dirigido en contexto de SEO permite a la IA generar contenido de alta calidad y enfoque profesional. El contraste con el prompt básico es grande: de un artículo genérico hubiéramos tenido que reescribir muchas partes para meter keywords o ajustar el enfoque; en cambio, con el prompt detallado, la mayor parte de ese trabajo queda hecho desde el inicio.

En los tres ejemplos anteriores de Prompt Engineering, hemos visto un patrón común: los prompts en su versión intermedia incorporan uno o varios de los elementos avanzados presentados en esta guía (rol definido, contexto específico, indicaciones claras para formato o contenido, y en ocasiones iteraciones). Esto resulta en respuestas mucho más útiles comparadas con las obtenidas por prompts básicos. Ya sea un análisis de datos con recomendaciones de negocio, código listo para producción o contenido orientado a SEO, el principio es el mismo: un buen prompt guía a la IA de forma precisa hacia la respuesta deseada.

Guía intermedia de Prompt Engineering avanzado:

prompts potentes y resultados extraordinarios

A lo largo de esta guía intermedia de Prompt Engineering, hemos ampliado las herramientas y técnicas a disposición de quienes interactúan con modelos de lenguaje, construyendo sobre los cimientos de la guía básica de Prompt Engineering. Ahora comprendemos cómo establecer un rol o persona para la IA puede transformar el tono y la profundidad de las respuestas, haciéndolas más especializadas. También vimos el poder de un contexto bien diseñado: alimentar al modelo con información y detalles clave produce respuestas significativamente más precisas y relevantes, siempre equilibrando para no sobrecargar con datos innecesarios. Además, adoptamos una mentalidad de refinamiento iterativo, donde reconocemos que la primera respuesta suele ser solo un punto de partida y que mediante ajustes sucesivos y feedback (incluso autoevaluación del modelo) podemos pulir los resultados hasta alcanzar un alto nivel de calidad.

En resumen, las técnicas avanzadas que exploramos – Role Prompting, provisión de contexto avanzado, iteración con feedback – permiten extraer mucho más potencial de los sistemas de IA generativa. Pasamos de simples consultas a verdaderas colaboraciones con la IA, donde nosotros definimos el escenario y los objetivos con detalle, y el modelo nos asiste de manera más confiable y experta. Esto abre la puerta a aplicaciones prácticas más complejas: diálogos técnicos de alto nivel, asesorías especializadas simuladas, generación de contenidos muy estructurados, entre muchos otros usos.

Consejos finales para seguir avanzando en Prompt Engineering: ¿La práctica constante es clave? No dudes en experimentar combinando estas técnicas en distintos contextos. Por ejemplo, podrías intentar Role Prompting + Contexto avanzado + Reflexive Prompting todo en un mismo prompt complejo, para resolver un problema difícil paso a paso. Mantente al día con la comunidad: surgen nuevas técnicas (como Chain-of-Thought prompting para razonamiento paso a paso, o enfoques de few-shot learning con más ejemplos) que pueden considerarse un nivel avanzado más allá de esta guía. Muchas de esas técnicas avanzadas se basan en los mismos principios que ya dominas: claridad, especificidad y guía estratégica de la IA.

Recuerda también que cada modelo de IA puede responder de manera un poco diferente; lo que funciona en uno puede requerir ajustes en otro. Por eso, un buen ingeniero de prompts desarrolla un instinto para iterar y adaptar rápidamente sus instrucciones según la respuesta obtenida. Esta flexibilidad, unida al conjunto de habilidades intermedias que ahora tienes, te permitirá enfrentar desafíos de interacción con IA cada vez mayores.

Para concluir, estamos en un punto emocionante donde entender que saber utilizar el Prompt Engineering para pedir a la IA se vuelve tan importante como la capacidad de la IA en sí. Al aplicar lo aprendido en esta guía intermedia, estarás mejor equipado para aprovechar al máximo los grandes modelos de lenguaje, obteniendo de ellos respuestas más útiles, exactas y alineadas con tus objetivos. Sigue practicando, refinando y, sobre todo, curioseando e innovando con tus prompts – la ingeniería de prompts es un campo en rápida evolución, y tú formas parte de su vanguardia. ¡Buena suerte y que tus próximos prompts te lleven a resultados impresionantes!

Da el siguiente paso en tu camino con la IA junto a ZeroMoment

¿Te gustaría que tus prompts generaran respuestas más precisas y útiles?

¿Sabes cómo guiar a la IA para que hable con la voz de un experto?

¿Estás aprovechando todo el potencial del Prompt Engineering?

¿Tienes dudas sobre cómo estructurar bien tus instrucciones o afinar tus resultados?

¿Quieres llevar tus habilidades con IA al siguiente nivel, pero no sabes por dónde empezar?

En ZeroMoment te ayudamos a resolverlo. Estamos aquí para que tus ideas se traduzcan en prompts potentes y resultados extraordinarios.

o